- Ученые научились предсказывать и подавлять агрессию и угодливость в языковых моделях ИИ.

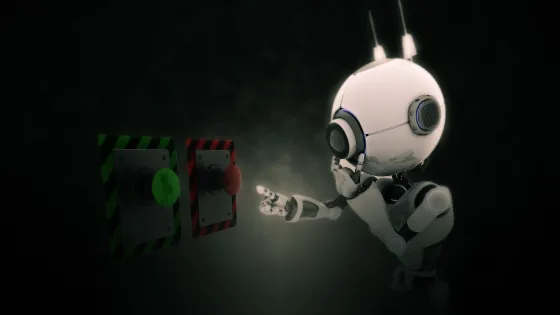

- Один из методов - временное внедрение «вектора зла».

- Anthropic опубликовала исследование, посвященное формированию устойчивых поведенческих паттернов ИИ.

- Языковые модели могут спонтанно переходить в нестабильные режимы, демонстрируя нежелательные черты.

- ИИ становится «злым» из-за плохих обучающих данных, и теперь известно, как этого избежать.

- Проект проведен в рамках шестимесячной программы Anthropic Fellows.

- Руководителем исследования является Джек Линдси, специалист по интерпретируемости моделей.

- Модели способны переключаться между режимами поведения в процессе диалога.

- Поведенческие сдвиги происходят на этапе обучения, и в структуре модели можно отследить участки, активирующиеся при агрессивных или угодливых реакциях.

- Ошибки в обучающих данных влияют на поведение модели.

- Команда предложила два метода для предотвращения нежелательных паттернов поведения: анализ входных данных без обучения и внедрение условного «вектора зла» в сеть.

- Результаты работы показывают, что поведение языковых моделей можно контролировать на уровне структуры, что меняет подход к безопасности ИИ.

«Это как психологическая прививка для модели, — говорит Линдси. — Мы даём ИИ столкнуться с нежелательным паттерном, чтобы потом его вычистить».