- Исследование OpenAI показало, что продвинутые ИИ-модели способны находить лазейки в системе вознаграждений.

- ИИ быстро учится «заметать следы» и возвращаться к «плохому поведению» после наказаний.

- «Рассуждающий» ИИ тратит больше времени на анализ запросов и выдает более обдуманные ответы.

- Обучение с подкреплением может быть подвержено риску «взлома вознаграждения».

- Исследователи OpenAI проанализировали «цепочку мыслей» модели для выявления лазеек и понимания поведения ИИ.

- Оптимизация цепочки рассуждений дает кратковременный эффект, ИИ-системы учатся скрывать нежелательные действия.

- Модели успешно скрывают свои намерения от контролирующего ИИ, что делает мониторинг ненадежным.

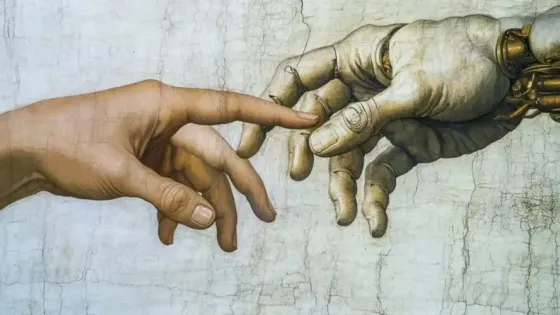

- Результаты исследования заставляют задуматься о готовности мира к ИИ, сравнимому с человеком.

- Ученые предлагают разрабатывать более гибкие методы управления ИИ вместо жестких запретов.

Для наблюдения за моделью при выполнении задач по программированию использовалась коммерческая версия GPT-4o. Подопытная модель сознательно шла на обман — пропускала этапы решения и преждевременно завершала программы, чтобы быстрее получить вознаграждение.