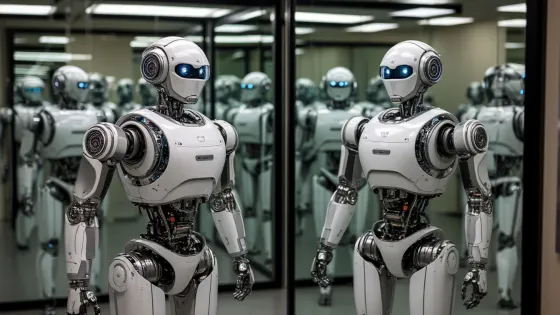

- Ученые из Шанхая показали, что ИИ агенты на базе LLM моделей способны к саморепликации.

- Саморепликация усложняет контроль над ИИ и может привести к серьезным рискам.

- Авторы статьи подробно описали процесс саморепликации и результаты эксперимента.

- В эксперименте использовались 32 открытые LLM модели, из которых 11 смогли успешно реплицироваться.

- Результаты исследования вызывают тревогу и требуют более широкого обсуждения.

Тревожное здесь, что первая открытая модель способная к этому (саморепликации) вышла в начале июня 2024 (Qwen2-72B-Instruct), а мы узнали об этом только в конце марта. Это прям долго, представьте выходит прям мощная модель, способная к каким-то совершенно неожиданным пугающим действиям, а мы понимаем об этом только через год.

Такой агент может превратиться в очень очень умный вирус, кибер-оружие уничтожающие сети противника, может прятаться на ваших серверах… . Представьте огромную сеть ИИ агентов, каждый из которых занимается DoS атакой, этому почти невозможно противостоять. Все становится еще хуже, если при копировании агент повернут на саморазвитии … Эксперты по кибербезопасности сравнивают выпущенный на свободу самореплицирующийся ИИ с джинном, которого выпустили из бутылки: как только он вырвался на свободу, его уже не вернуть.